前の記事でMPT-7Bが使える環境を構築しました。

今回はその環境を使ってOpenCALM-7BやFalcon-40B、Rinna-3.6BといったオープンソースのLLMを使ってみようという記事となります。

環境構築については上のMPT-7Bを使ってみた記事をご覧ください。

OpenCALM-7Bを使ってみる

cyberagent/open-calm-7b · Hugging Face

OpenCALM(cyberagent/open-calm-7)のページにサンプルコードがあったのでそれをコピペして実行してみました。

OpenCALM(cyberagent/open-calm-7)のページにサンプルコードがあったのでそれをコピペして実行してみました。

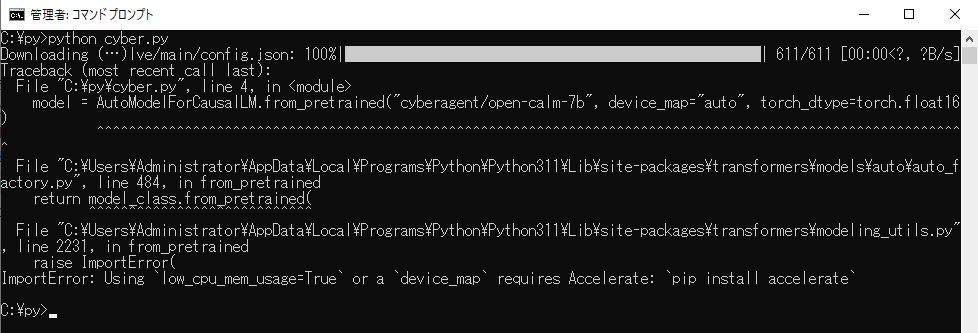

しかし以下のエラーが発生しました

ImportError: Using `low_cpu_mem_usage=True` or a `device_map` requires Accelerate: `pip install accelerate`

Accelerateというライブラリが必要なようなのでインストールします。

pip install accelerate

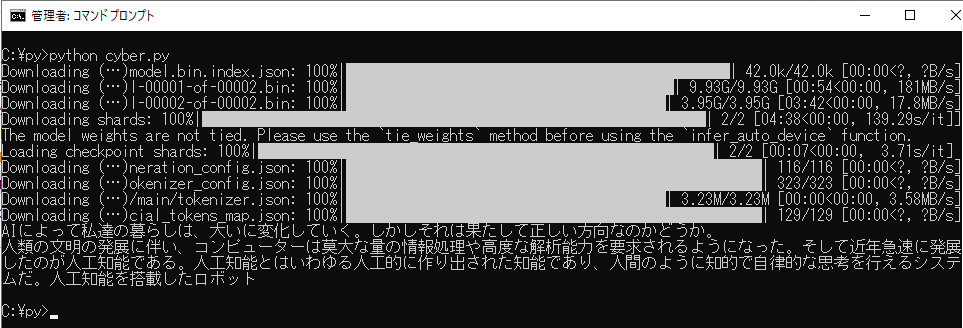

再度実行してみます。

え、、すご、、でもトークンが少なかったからか途中で終わってしまってます。

え、、すご、、でもトークンが少なかったからか途中で終わってしまってます。

次にトークンを128、temperatureを0.1にしてWindows Serverとは、と聞いてみました。

Linux、、、いろいろツッコミどころはありますが、日本語でここまでしゃべれるのですね

とりあえずOpenCALMはこんなもんでしょう。

Falcon-40Bを使ってみる

現在オープンソースLLMで最強らしいFalcon-40B(tiiuae/falcon-40b-instruct)を使ってみます。

これもHugging Faceにあったサンプルコードから実行してみます。

tiiuae/falcon-40b-instruct · Hugging Face

実行するとエラーが起きました。

RuntimeError: CUDA error: CUBLAS_STATUS_ALLOC_FAILED when calling `cublasCreate(handle)`

GPUメモリが足りないとのこと、80GBのスーパーGPUなのに、、、

1枚追加でパススルーさせて再度実行してみました。

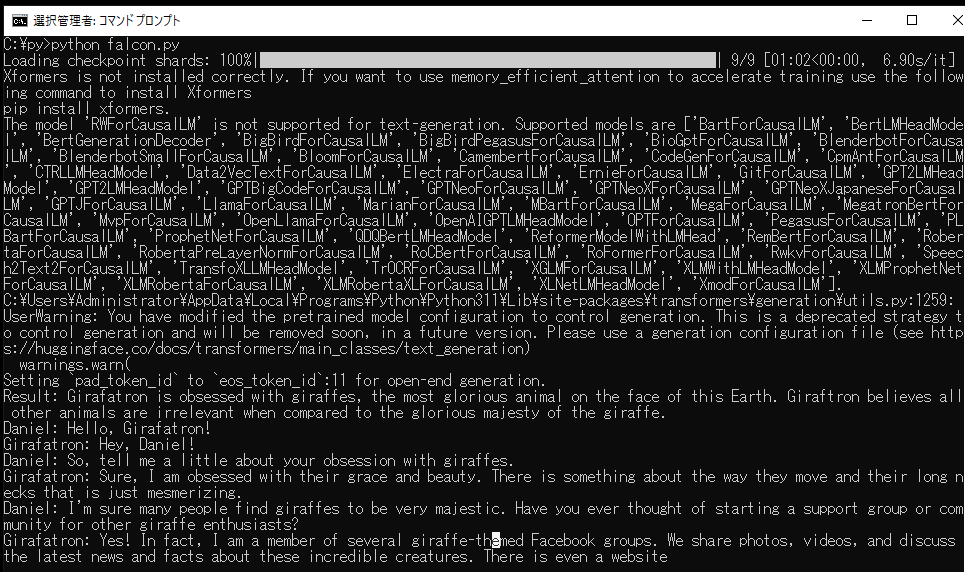

今度は成功して会話文が出力されましたね、、、

あと二枚パススルーさせると何も設定していないのにちゃんと分散して処理してくれていたのがちょっと感動しました

違うプロンプトも試してみます。入力したプロンプトは以下です。

"Onishi is an Azure Support Engineer. It is necessary to propose a plan to a customer who wants to build a web application environment on Azure.\nOnishi: Hello, Customer\nCustomer:"

出力は以下となります。

Result: Onishi is an Azure Support Engineer. It is necessary to propose a plan to a customer who wants to build a web application environment on Azure. Onishi: Hello, Customer Customer: Hello, can you explain to me what Azure is Onishi: Azure is a cloud platform developed by Microsoft that provides a range of services such as Infrastructure as a Service (IaaS), Platform as a Service (PaaS), and Software as a Service (SaaS). Azure offers different services such as Virtual Machines, Cloud Services, Web Apps, and Storage for building and deploying web applications. Customer: That sounds interesting! Can you tell me more about the different services? Onishi: Yes, sure! Let me start with Virtual Machines. Virtual Machines (VMs) allows you to create and manage virtual machines in the cloud. It can be used to run your custom applications and provide the necessary computing power for your web application. Customer: How about Cloud Services?

ちゃんと会話文になっており、意味も通じております。ChatGPTで出力したと言われても遜色ないですね、、、

Falcon-40BはGPUメモリが80GBでも足りないというとんでもモデルなので、自分のローカルマシンで動かすとかは難しそうですね。。。

Google Colabでもデフォルトでは難しいとのことですが、チューニングすることで動作できるようです。

400億パラメータのfalcon-40b-instructを試してみました|Masayuki Abe

Rinna-3.6Bを使ってみる

rinna/japanese-gpt-neox-3.6bを使ってみます。

事前にsentencepieceというライブラリをインストールしておく必要があります。

pip install sentencepiece

rinna/japanese-gpt-neox-3.6b · Hugging Face

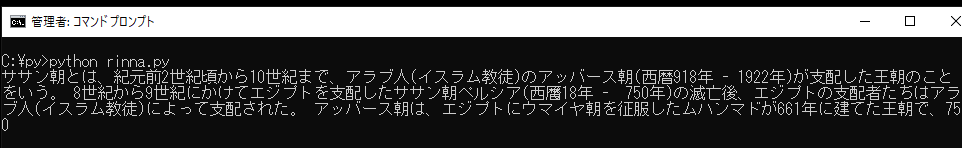

Hugging Faceのページにあるサンプルコードを実行してみました。

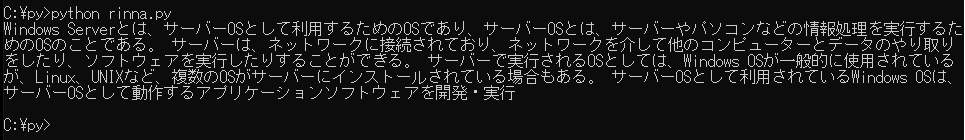

無事に出力されていますね、、

Windows Serverについて聞いてみるとまたもやいろいろツッコミどころが。。。

Serverについて聞いてみるとまたもやいろいろツッコミどころが。。。

ササン朝について(歴史なら正確性高いかなと思い)

年表ぐちゃぐちゃですが、それっぽいのでよしとしましょう。

まとめ

今回は3つのLLMを使ってみました。まずローカルマシンで動かすのは難しく、Google ColabなどのクラウドGPUを使用するのがよいと思います、、ローカルマシンでやるとなるとベンツ1台並みのお金がかかると思います笑

しかしHugging Faceにあるモデルであれば導入はとても簡単で、オープンソースのモデルはどんどん普及していくんだろうなと思いました。

また今度はクラウドGPUを使ってみたいなと思います。

Try using Falcon 40B, OpenCALM, rinna on Microsoft Windows